RAG 是什麼?為什麼現在特別重要?

傳統的大語言模型(LLM)主要依靠預訓練時期的知識來生成答案,但這些知識有兩個致命缺點,容易過時、答非所問,甚至產生幻覺。RAG(Retrieval-Augmented Generation) 透過「先檢索、再生成」,讓答案有來源、有依據,兼顧正確性與即時性。

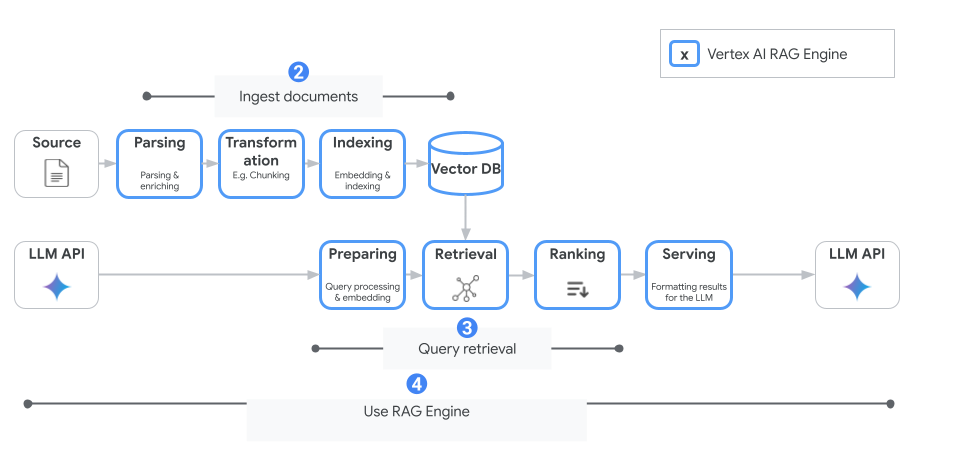

對企業來說,這種能力至關重要——沒有 RAG,生成式 AI 難以在真實業務環境中落地。這也是為什麼 Google 在 Vertex AI 裡推出 RAG Engine,用受管服務把整條鏈路(擷取 → 嵌入 → 索引 → 檢索 → 生成)包起來,讓團隊可以更快、更安全地啟動 RAG 專案。

RAG、Grounding、Search:三者怎麼分?

在討論 Vertex AI RAG Engine 前,先弄清楚這三個名詞的差別。

- Search:傳統檢索,把最相關的資料找出來,但不一定能生成完整答案。

- RAG(Retrieval-Augmented Generation):先檢索,再把找到的內容餵進模型生成回覆,兼具資料依據與自然語言表達。

- Grounding(錨定):要求生成內容必須錨定在可信來源,確保答案可驗證,降低「幻覺」風險。

幾個關鍵角度比較

- 正確性:Grounding > RAG > Search

- 可追溯性:Grounding > RAG > Search

- 創造性:Search > RAG > Grounding

- 成本與複雜度:Search < RAG < Grounding

👉 簡單來說,RAG 在正確性與創造性之間取得平衡,既不像 Search 那樣缺乏依據,也不會像 Grounding 那樣過度受限;而在成本上,RAG 也比 Grounding 更容易落地。

RAG 的定位與案例數據

對大多數企業來說,RAG 是「速度快、效果佳」的折衷方案:

- 比 Search 更聰明:不只找到資料,還能生成自然流暢的回答。

- 比完全 Grounding 更省力:不需要大規模工程與合規維運,也能有效降低幻覺。

- 正確率提升:研究與 Google 官方案例指出,RAG 在知識問答與文件檢索的場景中,能把回答正確率從 60–70% 提升到 80–90%,同時把幻覺錯誤降低 20–40%。

- 常見應用:企業知識庫、客服自動化、醫療與金融文件檢索,大多都是先用 RAG 起步,再逐步強化 Grounding。

Vertex AI 如何支援 RAG?

自己從零開始實作 RAG,需要處理很多細節:

文件解析、分段切塊(chunking)、嵌入向量產生、建立索引、檢索與重排序,最後再把檢索結果餵給模型生成答案。這些步驟看似簡單,實際上需要跨多個工具與維運,對團隊來說是龐大的負擔。

Google 在 Vertex AI 裡提供了 RAG Engine,讓這些流程能以 受管(managed)服務 的方式完成,開發者只需透過簡單的 API,就能從資料匯入到答案生成一路跑通。

RAG Engine 的核心功能

- 資料匯入與解析

支援多種常見文件格式(PDF、TXT、網頁等),能自動完成資料清理與分段,減少前處理時間。 - 嵌入與索引

內建嵌入模型,並可直接對接 Vertex AI Vector Search 或第三方向量庫(如 Pinecone、Weaviate),讓檢索效能更快。 - 檢索與重排序

系統會自動從索引中找到最相關的片段,並用排序模型(re-ranker)優化結果,確保丟進模型的上下文最有用。 - 生成與錨定

把檢索到的內容餵給 LLM 回答,並可設定「必須引用來源」,大幅降低幻覺(hallucination),讓答案更可信。

👉 核心價值:團隊不需要再花大量時間維護檢索與編排基礎設施,可以專注在應用場景與使用者體驗。

RAG 系統建構的三種路徑

在企業導入 RAG 時,不同的團隊需求與資源差異很大:

- 有些公司只想快速上線,不希望碰到太多技術細節;

- 有些團隊需要一定的彈性,但又不想從零開始維運;

- 還有一些大型企業或高合規場景,則必須完全掌控系統,自己組建與維護。

因此,Google 在 Vertex AI 中設計了三種不同的選擇,對應不同情境:

| 方案 | 適合對象 | 優點 | 缺點 |

|---|---|---|---|

| Vertex AI Search | 想快速啟用知識檢索、FAQ 問答的企業 | 開箱即用、上線最快、內建權限控管 | 彈性有限,無法深度客製化 |

| Vertex AI RAG Engine | 想兼顧開發速度與一定客製化的團隊 | 受管管線,省去維運;可替換嵌入模型或向量庫 | 仍在 Google 框架下,特殊需求可能受限 |

| 完全自建(DIY RAG) | 大型團隊、高合規或特殊場景 | 自由度最高,可完全掌控架構與流程 | 工程量與維運成本最高,需要處理安全、效能、監控 |

部署與注意事項

在落地 Vertex AI RAG Engine 時,除了前面提到的功能與選型外,這些部署與環境上的限制也非常關鍵,建議在規劃時先確認:

- 配額與操作限制

- RAG Engine 的各種 API 請求與作業(匯入檔案、檢索請求等)有固定的每分鐘請求上限;匯入檔案時併發請求、每次匯入最大檔案數、JSON/TXT 或其他格式的支援也可能受限。若 “資料量” 或 “請求數” 特別大,要提前申請/估算配額需求。

- 加密與安全控制

- RAG Engine 支援 CMEK(客戶管理加密金鑰)以控制資料靜態加密,讓你可以自己管理 KMS 金鑰。也支援 VPC Service Controls(VPC-SC)的網路隔離策略,以提高資料安全。官方也提醒,CMEK 的設定一旦在 corpus 建立,就無法變更,並且在一個 project + 區域中使用的 CMEK 金鑰數有上限(最多 50 個)。

- 資料駐留與合規性限制

- 注意目前 Data Residency 與 AXT 安全控制 尚未被支援,若您在某些國家或行業有法律、政策要求資料必須保留在特定地理區域或設有特定審計/安全控制,這可能會是阻礙。要先確認目標區域是否可用,並與 Google 支援確認相關政策。

- 區域功能差異與穩定度

- 雖然某些歐洲區域(如 europe-west3, europe-west4)被列為支援 region,但部分使用者反映 “上傳文件” 或 “建立 corpus” 等操作在這些地區的實際功能可能有延遲或尚未完全可用。若你的業務對 GDPR 或本地資料存放有要求,就要先測試這些功能在地是否穩定可用。

與勤英科技一起啟動你的 RAG 應用

RAG 已經成為企業導入生成式 AI 的務實起點,而 Google Cloud 的 Vertex AI 提供不同層級的選項,能協助團隊快速從 POC 驗證到正式上線。

然而,對許多企業來說,挑戰並不僅止於技術本身,而在於如何:

- 正確選型:判斷是用 Search、RAG Engine 還是完全自建。

- 控管成本:避免因為錯誤設計導致運算資源浪費。

- 兼顧合規與維運:在高標準的安全與法規需求下仍能順利落地。

這正是 勤英科技 Elite Cloud 的價值所在:

- 我們是 Google Cloud 官方認證合作夥伴,同時具備 多雲整合與成本優化 的深厚經驗。

- 能協助企業在 設計與部署 Vertex AI RAG 架構 的過程中,降低試錯成本,加速專案落地。

- 針對不同產業(金融、醫療、法務、零售),我們能提供符合合規要求的最佳實踐方案,確保 AI 應用不只是能用,而是能長期維運。

👉 如果你正考慮將私有資料與生成式 AI 結合,或想要在 Vertex AI 上快速啟動 RAG 應用,歡迎與勤英科技聯繫。我們將提供專業顧問服務,幫助你打造最適合的 AI 解決方案。

*參考資料: Google Blog